Projekte im Wintersemester 2016/17

Projektvergabe

Die Projektvergabe für das Wintersemester 2016/17 findet am 05.10.2016 um 12:15 - 13:45 Uhr im Raum WH C 349 statt. Den Projektvergabetermin finden Sie auch im LSF unter den Modulen M11A Praxisphase Teil 1.

Die Teilnahme an dieser Veranstaltung ist Voraussetzung, um an einem Projekt teilnehmen zu können. Bitte beachten Sie die Hinweise zur Projektvergabe.

Studierende, die in die Projektphase 2 eintreten, brauchen nicht zu erscheinen. Bitte melden Sie Sich im LSF zur Phase 2 einfach an. Die Zulassung für Studierende der Projektphase 2 erfolgt automatisch nach dem Semesterbeginn.

Seiteninhalt

Erschließungs- und Visualisierungswerkzeuge für den Imagekatalog der Musikabteilung der Staatsbibliothek zu Berlin

David Zellhöfer

Der „Alphabetische Imagekatalog der Musikabteilung“ umfasst ca. eine

Million gescannte Katalogzettel, die mittels einer Web-Anwendung

interessierten Nutzerinnen und Nutzer präsentiert werden

(http://musikipac.staatsbibliothek-berlin.de/catalog/toc). Um diese

teils unikalen Bestände der Staatsbibliothek besser durchsuchbar zu

machen, muss der Katalog mittelfristig einer Retrokonversion

(http://de.wikipedia.org/wiki/Retrokonversion) unterzogen werden. Ziel

des Projektes ist es, geeignete Werkzeuge zu entwickeln, die sowohl

Bibliothekarinnen und Bibliothekare sowie Nutzerinnen und Nutzer bei

folgenden Tätigkeiten zu unterstützen:

1. Überführung der teils handschriftlichen, mehrsprachigen

Katalogscans mittels OCR in ein strukturiertes Datenformat, welches z.B.

Signaturen, Komponisten oder Titel umfasst

2. Durchsuchung des erzeugten, fehlerhaften Datenbestands mittels

geeigneter Information-Retrieval-Algorithmen

3. Visualisierung des entstandenen Datenraums z.B. mittels

Cluster-Algorithmen, um ähnliche Datensätze darzustellen

4. Präsentation der Arbeitsergebnisse mittels einer Web-Anwendung,

die gängigen Usability- und Accessibility-Anforderungen genügt

In einer ersten Projektphase wurde bereits eine Web-Anwendung durch

Studierende der HTW entwickelt, welche den grundsätzlichen Workflow (mit

Schwerpunkt auf 1 und 2) implementiert und dokumentiert. Das aktuelle

Projekt sollte vor allem die Korrektur, Anreicherung und Analyse des

Datenbestands im Fokus haben. Hierbei sind Methoden des Information

Retrievals, des maschinellen Lernens und der damit verbundenen

Clustervisualisierungen sinnvoll zu verbinden. Die Ergebnisse sollten in

einer Web-basierten GUI präsentiert werden, so dass es möglich wird,

sich die existierenden Daten explorativ zu erschließen und sie effektiv

zu korrigieren.

Das Projekt hat einen klaren Forschungsschwerpunkt, so dass es der

Projektgruppe frei steht, die Projektziele in Absprache mit dem Team der

Staatsbibliothek zu definieren und anzupassen. Das Projekt wird durch

IT- und Bibliothekspersonal begleitet. Im Gegensatz zu üblichen Ansätzen

versucht das Projekt nicht die OCR-Qualität zu optimieren sondern

erkennt an, dass die Texterkennungsqualität nach oben hin begrenzt ist.

Mithilfe von Techniken aus dem Spannungsfeld Information Retrieval,

maschinellem Lernen und angemessenen Visualisierung soll vielmehr

versucht werden auch schlechte OCR-Qualität im Nachgang zu kompensieren

und trotzdem zu auswertbaren Daten zu kommen. Dieser Ansatz ist hoch

experimentell und ermöglicht kreative Gestaltungsmöglichkeiten und

Zugänge zu einem einzigarten Datenpool.

Weitere Informationen zum Projektfortschritt finden sich unter

github.com/kaphka/htwmusik und

github.com/kaphka/catalog-ocr-test .

hAPPening - Informationshub für Veranstalter, Aussteller und Besucher

Prof. Carsten Busch u.a.

Veranstaltungen bieten Raum zum Informationen austauschen, Präsentieren und Netzwerken. Dies möchten wir unterstützen, indem wir Wege und Lösungen erarbeiten, die einen interaktiven Austausch zwischen allen beteiligten Parteien zu ermöglichen. Damit in Zukunft jede Veranstaltung auch ihren eigenen Informationshub in Form einer App haben kann, werden wir untersuchen, inwiefern Anwendungen für Smartphones generisch gehalten werden können. Während der ersten Projektphase werden wir uns darauf konzentrieren diesen Informationshub für alle beteiligten Parteien zu erschaffen. Im zweiten Schritt werden zunächst Module entwickelt, um den Hub mit Funktionen zum Leben zu erwecken und so die Kommunikation zwischen Veranstaltungsteilnehmern positiv zu beeinflussen. Die dritte Phase widmet sich der Einbindung von Techniken zur ortsbasierten Interaktion. Denkbar ist hier die Verwendung von NFC, Beacons oder auch VR, AR. Hierdurch soll der direkte Bezug zwischen Menschen in ihrer unmittelbaren Umgebung garantiert werden.

Unser Ziel ist es, ein Konzept sowie einen Arbeitsprozess zu entwickeln, durch welche Veranstalter, Aussteller und Besucher die Möglichkeit erhalten, während einer Veranstaltung Informationen untereinander auszutauschen. Durch diese Art der interaktiven Kommunikation sollen Veranstaltungen in Zukunft interaktiver gestaltet werden können. Unseren Prototypen werden wir am Beispiel der IMI Showtime präsentieren.

Automatische Lehreinsatzplanung

Prof. Gefei Zhang

An der HTW wird vor jedem Semester die "Lehreinsatzplannung" durchgeführt. Dabei geben die Dozenten ihre Wunschtermine für die Lehre sowie Rhythmus ihrer Veranstaltungen, Ausstattungsanforderungen etc. ein, und die Verwaltung erstellt auf Basis dessen manuell den Stundenplan für das neue Semester. Da die Eingabe der Dozenten in textueller Form erfolgt und insbesondere bei den Terminwünschen der Dozenten häufig Kollisionen bestehen, ist es sehr aufwendig, die Interessen und Anforderungen aller Beteiligten zu berücksichtigen und einen konfliktfreien Plan zu erarbeiten.

In diesem Projekt soll eine Web-Anwendung entwickelt werden, mit der die Dozenten ihre Wünsche und Anforderungen graphisch eingeben können, und die automatisch einen "fast-optimalen" Plan berechnet. Dabei soll insbesondere ein Konzept für die Benutzereingabe erarbeitet werden, und die Optimierung durch randomisierte Algorithmen erfolgen.

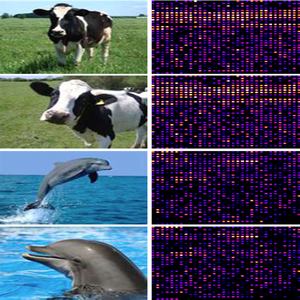

Keyword Search for Images without Keywords

Nico Hezel

Dieses Projekt geht nur über ein Semester, näheres dazu bei der Projektvergabe.

Das Suchen von Fotos auf dem eigenen Computer nach Datum oder zuvor vergebenen Tags ist schon lange möglich. Ziel dieses Masterprojekts ist es, eine beliebige Fotosammlung auf dem Computer mithilfe von Machine Learning Verfahren zu analysieren und diese automatisch inhaltlich durchsuchbar zu machen. Die vom System zugewiesenen Informationen sollen für den Anwender nicht einsehbar sein, aber eine Schlagwort-basierte Suche soll die entsprechenden Bilder dennoch auffindbar machen.

In der ersten Phase des Projekts wurde bereits ein erster Prototyp als Desktop-Applikation entwickelt. Hiermit können Nutzer lokal auf ihrem Computer und auch ohne bestehende Internetverbindung über Texteingaben nach Bildern suchen. Die Applikation ist in der Lage, den Inhalt von Bildern mit der Hilfe eines neuralen Netzwerks zu erkennen, was das Durchsuchen von großen Bildergalerien ohne zuvor gesetzte Tags ermöglicht.

In der zweiten Projektphase werden Sie lernen, mit Machine Learning Frameworks umzugehen und mit diesen die Anwendung noch weiter zu verbessern. Das bestehende Programm soll weiterentwickelt werden, so dass mehr Schlagworte verstanden werden und die Suche schneller wird. Idealerweise wird alles performant genug, um eine neue Applikation auf einem mobilen Endgerät laufen zu lassen.

TARMAGOSKI

Prof. Tobias Lenz

Wie der Titel bereits deutlich macht, geht es um die Verwendung komplexer Verfahren der künstlichen Intelligenz, um virtuellen Wesen über einfache Interaktion ein Verhalten anzutrainieren. Die Wesen "leben" auf dem Smartphone, sollen mit ausgewählten virtuellen Gegenständen interagieren können und Feedback über ihr Verhalten durch den Nutzer bekommen (Lächeln in die Kamera, Schütteln des Smartphones, Touchgesten, ...). Findet man andere Wesen auf Smartphones in der näheren Umgebung, sollen diese (z.B. über Bluetooth) im Rahmen ihres gelernten Verhaltens interagieren können und im Idealfall voneinander lernen.

Zu Beginn wird umfassend nach der geeigneten Lernmethode (Reinforcement Learning? Neuronale Netze?) gesucht und es werden die KI-Grundlagen gelegt, anschließend kann man sich dann mit den technischeren Dingen zur Ein- und Ausgabe beschäftigen wie Smartphone-Sensoren, Augmented (oder Virtual?) Reality, Kommunikation im Nahbereich, ...